概述:把一段文字划分为一个个的关键字,我们在搜索时会把自己的信息进行分词,会把数据库中或索引库中的数据进行分词,然后进行匹配操作,默认的中文分词是将一个字看作一个词,如:你好谢谢,“你”,“好”,“谢”,“谢”,这种分词方式显然是不合理的,需要IK中文分词器来解决该问题。

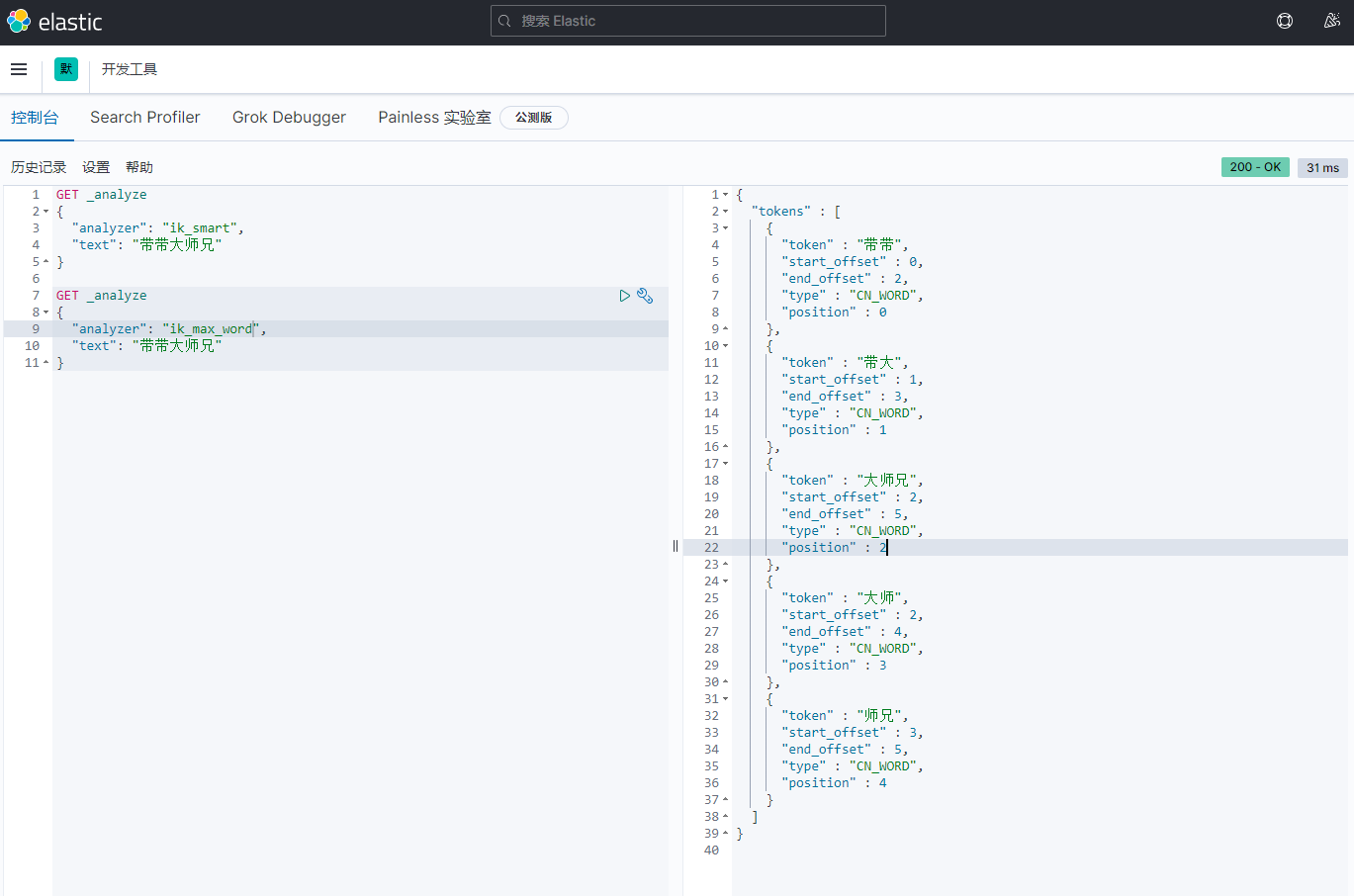

IK提供了ik_smart,ik_max_word两种分词算法

不同的分词效果

ik_smart 最少切分

ik_max_word 最细粒度划分

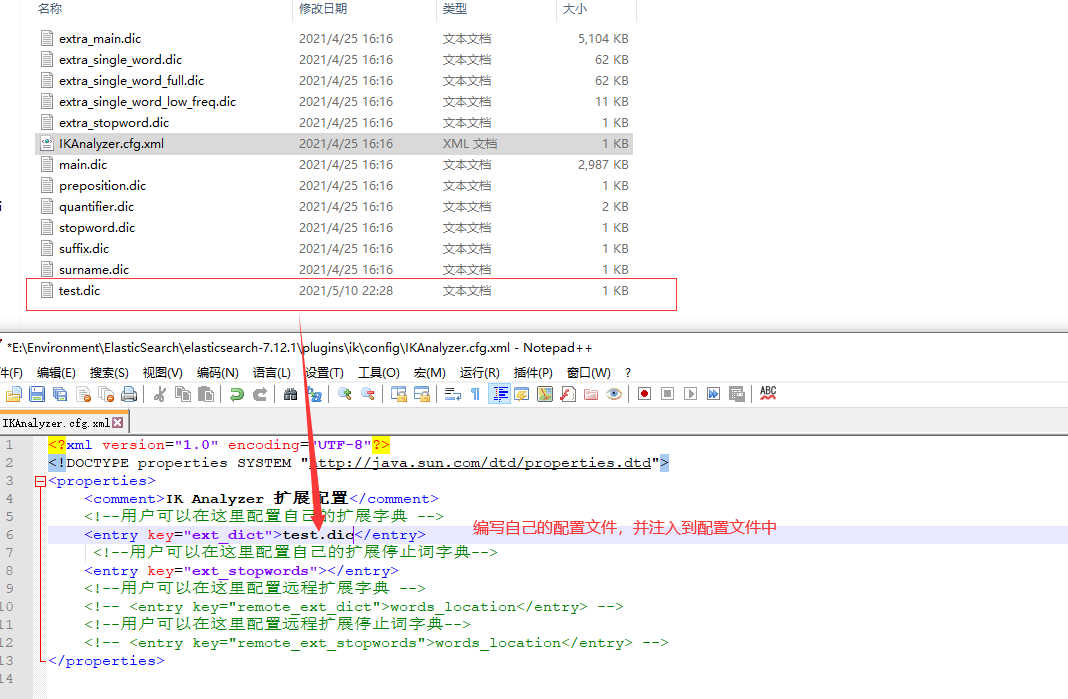

Ik分词器增加自己的配置

重启es并测试

概述:把一段文字划分为一个个的关键字,我们在搜索时会把自己的信息进行分词,会把数据库中或索引库中的数据进行分词,然后进行匹配操作,默认的中文分词是将一个字看作一个词,如:你好谢谢,“你”,“好”,“谢”,“谢”,这种分词方式显然是不合理的,需要IK中文分词器来解决该问题。

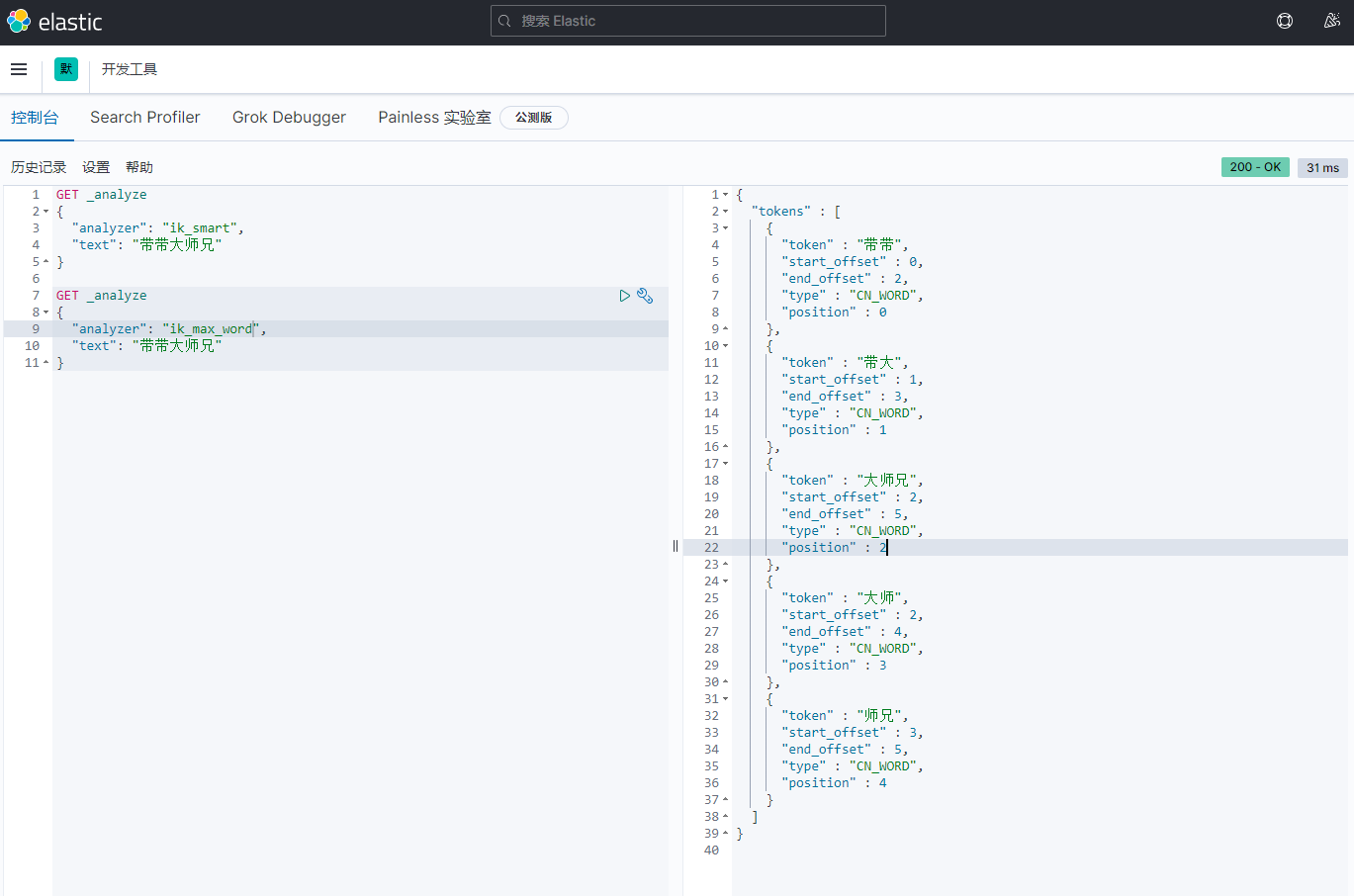

IK提供了ik_smart,ik_max_word两种分词算法

不同的分词效果

ik_smart 最少切分

ik_max_word 最细粒度划分

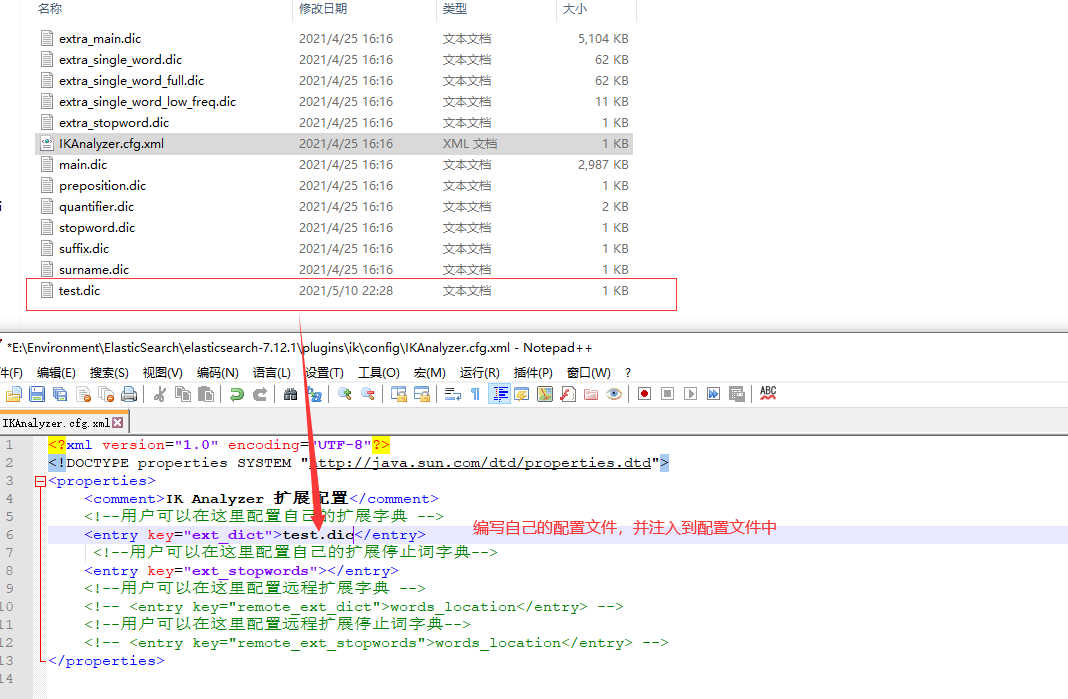

Ik分词器增加自己的配置

重启es并测试

评论 (0)