搜索到

46

篇与

的结果

-

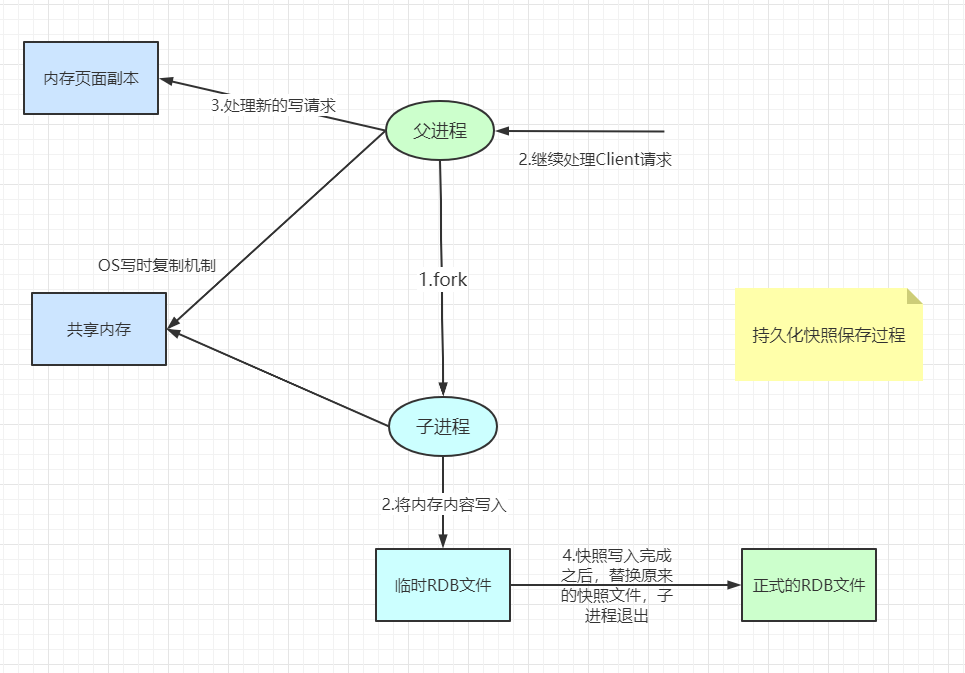

Redis持久化 Redis持久化RDB(Redis DataBase)在指定的时间间隔内将内存中的数据集体写入磁盘(Sanpshot快照),恢复时将快照文件直接读取到内存中触发机制1、满足save规则的情况时2、执行flushall3、退出redis时,也会产生rdb文件如何恢复rdb文件将rdp文件放在redis的启动目录即可,redis启动时会自动检查dump.rdb文件,恢复其中的数据# 查看目录 127.0.0.1:6379> config get dir 1) "dir" 2) "/usr/local/bin" 127.0.0.1:6379> 优点:适合大规模的数据恢复对数据的完整性不敏感的业务缺点:操作需要一定的时间间隔,特殊情况下,最后一次的修改数据可能会丢失(宕机)fork进程时,会占用一定的空间AOF(Append Only File)以日志的形式记录每个写的操作,将Redis执行过程的所有指令记录下来(不记录读操作),只追加文件不允许改写文件,redis启动时会读取该文件重新构建数据,即:启动时根据日志文件的内容,将写操作从头到尾执行一次已完成数据恢复。redis.conf配置配置文件默认不开启aof,需手动设置为yes,重启redis即可生效重写规则当文件大小超过64mb时,会fork一个新的进程来重写文件(文件占用的内存空间会越来越大)redis-check-aofaof文件有误,redis启动失败如果aof文件中存在错误,可用redis-check-aof --fix命令修复这个文件修复完成之后重新启动redis即可优点:没修改一次,都会进行同步,数据的完整性更好效率更高缺点:每秒同步一次,极端情况下可能会丢失最后一秒的数据aof文件远大于rdb文件,修复速度也比rdb慢整体运行效率比rdb慢RDB与AOF对比:图片来源:狂神说Java

Redis持久化 Redis持久化RDB(Redis DataBase)在指定的时间间隔内将内存中的数据集体写入磁盘(Sanpshot快照),恢复时将快照文件直接读取到内存中触发机制1、满足save规则的情况时2、执行flushall3、退出redis时,也会产生rdb文件如何恢复rdb文件将rdp文件放在redis的启动目录即可,redis启动时会自动检查dump.rdb文件,恢复其中的数据# 查看目录 127.0.0.1:6379> config get dir 1) "dir" 2) "/usr/local/bin" 127.0.0.1:6379> 优点:适合大规模的数据恢复对数据的完整性不敏感的业务缺点:操作需要一定的时间间隔,特殊情况下,最后一次的修改数据可能会丢失(宕机)fork进程时,会占用一定的空间AOF(Append Only File)以日志的形式记录每个写的操作,将Redis执行过程的所有指令记录下来(不记录读操作),只追加文件不允许改写文件,redis启动时会读取该文件重新构建数据,即:启动时根据日志文件的内容,将写操作从头到尾执行一次已完成数据恢复。redis.conf配置配置文件默认不开启aof,需手动设置为yes,重启redis即可生效重写规则当文件大小超过64mb时,会fork一个新的进程来重写文件(文件占用的内存空间会越来越大)redis-check-aofaof文件有误,redis启动失败如果aof文件中存在错误,可用redis-check-aof --fix命令修复这个文件修复完成之后重新启动redis即可优点:没修改一次,都会进行同步,数据的完整性更好效率更高缺点:每秒同步一次,极端情况下可能会丢失最后一秒的数据aof文件远大于rdb文件,修复速度也比rdb慢整体运行效率比rdb慢RDB与AOF对比:图片来源:狂神说Java -

SpringBoot整合Redis jedis:采用直连,多个线程操作是不安全的,为了安全起见可以使用jedis pool,更像BIO模式lettuce:采用netty,实例可以在多个线程中进行共享,不存在线程不安全的情况,更像NIO模式==SpringBoot 2.0之后默认采用lettuce==源码:public class RedisAutoConfiguration { @Bean @ConditionalOnMissingBean(name = "redisTemplate") //可以自定义redisTemplate @ConditionalOnSingleCandidate(RedisConnectionFactory.class) public RedisTemplate<Object, Object> redisTemplate(RedisConnectionFactory redisConnectionFactory) { //默认的RedisTemplate没有过多的设置,redis对象都需要序列化 //两个泛型都是<Object,Object>,使用时需要强转为<String,Object> RedisTemplate<Object, Object> template = new RedisTemplate<>(); template.setConnectionFactory(redisConnectionFactory); return template; } @Bean @ConditionalOnMissingBean //由于String是redis中的常用类型,所以将其单独列出注册到Spring容器中 @ConditionalOnSingleCandidate(RedisConnectionFactory.class) public StringRedisTemplate stringRedisTemplate(RedisConnectionFactory redisConnectionFactory) { StringRedisTemplate template = new StringRedisTemplate(); template.setConnectionFactory(redisConnectionFactory); return template; }自定义RedisTemplatepackage com.sw.config; import com.fasterxml.jackson.annotation.JsonAutoDetect; import com.fasterxml.jackson.annotation.PropertyAccessor; import com.fasterxml.jackson.databind.ObjectMapper; import org.springframework.context.annotation.Bean; import org.springframework.context.annotation.Configuration; import org.springframework.data.redis.connection.RedisConnectionFactory; import org.springframework.data.redis.core.RedisTemplate; import org.springframework.data.redis.serializer.Jackson2JsonRedisSerializer; import org.springframework.data.redis.serializer.StringRedisSerializer; /** * @Author suaxi * @Date 2021/1/2 14:24 */ @Configuration public class RedisConfig { //自定义RedisTemplate @Bean @SuppressWarnings("all") public RedisTemplate<String, Object> redisTemplate(RedisConnectionFactory factory) { RedisTemplate<String, Object> template = new RedisTemplate<>(); template.setConnectionFactory(factory); //Json序列化配置 Jackson2JsonRedisSerializer jackson2JsonRedisSerializer = new Jackson2JsonRedisSerializer(Object.class); ObjectMapper om = new ObjectMapper(); om.setVisibility(PropertyAccessor.ALL, JsonAutoDetect.Visibility.ANY); om.enableDefaultTyping(ObjectMapper.DefaultTyping.NON_FINAL); jackson2JsonRedisSerializer.setObjectMapper(om); //String序列化 StringRedisSerializer stringRedisSerializer = new StringRedisSerializer(); //key采用String的形式序列化 template.setKeySerializer(stringRedisSerializer); //hash采用String的形式序列化 template.setHashKeySerializer(stringRedisSerializer); //value序列化方式采用jackson template.setValueSerializer(jackson2JsonRedisSerializer); //hash的value序列化方式采用jackson template.setHashValueSerializer(jackson2JsonRedisSerializer); template.afterPropertiesSet(); return template; } }

SpringBoot整合Redis jedis:采用直连,多个线程操作是不安全的,为了安全起见可以使用jedis pool,更像BIO模式lettuce:采用netty,实例可以在多个线程中进行共享,不存在线程不安全的情况,更像NIO模式==SpringBoot 2.0之后默认采用lettuce==源码:public class RedisAutoConfiguration { @Bean @ConditionalOnMissingBean(name = "redisTemplate") //可以自定义redisTemplate @ConditionalOnSingleCandidate(RedisConnectionFactory.class) public RedisTemplate<Object, Object> redisTemplate(RedisConnectionFactory redisConnectionFactory) { //默认的RedisTemplate没有过多的设置,redis对象都需要序列化 //两个泛型都是<Object,Object>,使用时需要强转为<String,Object> RedisTemplate<Object, Object> template = new RedisTemplate<>(); template.setConnectionFactory(redisConnectionFactory); return template; } @Bean @ConditionalOnMissingBean //由于String是redis中的常用类型,所以将其单独列出注册到Spring容器中 @ConditionalOnSingleCandidate(RedisConnectionFactory.class) public StringRedisTemplate stringRedisTemplate(RedisConnectionFactory redisConnectionFactory) { StringRedisTemplate template = new StringRedisTemplate(); template.setConnectionFactory(redisConnectionFactory); return template; }自定义RedisTemplatepackage com.sw.config; import com.fasterxml.jackson.annotation.JsonAutoDetect; import com.fasterxml.jackson.annotation.PropertyAccessor; import com.fasterxml.jackson.databind.ObjectMapper; import org.springframework.context.annotation.Bean; import org.springframework.context.annotation.Configuration; import org.springframework.data.redis.connection.RedisConnectionFactory; import org.springframework.data.redis.core.RedisTemplate; import org.springframework.data.redis.serializer.Jackson2JsonRedisSerializer; import org.springframework.data.redis.serializer.StringRedisSerializer; /** * @Author suaxi * @Date 2021/1/2 14:24 */ @Configuration public class RedisConfig { //自定义RedisTemplate @Bean @SuppressWarnings("all") public RedisTemplate<String, Object> redisTemplate(RedisConnectionFactory factory) { RedisTemplate<String, Object> template = new RedisTemplate<>(); template.setConnectionFactory(factory); //Json序列化配置 Jackson2JsonRedisSerializer jackson2JsonRedisSerializer = new Jackson2JsonRedisSerializer(Object.class); ObjectMapper om = new ObjectMapper(); om.setVisibility(PropertyAccessor.ALL, JsonAutoDetect.Visibility.ANY); om.enableDefaultTyping(ObjectMapper.DefaultTyping.NON_FINAL); jackson2JsonRedisSerializer.setObjectMapper(om); //String序列化 StringRedisSerializer stringRedisSerializer = new StringRedisSerializer(); //key采用String的形式序列化 template.setKeySerializer(stringRedisSerializer); //hash采用String的形式序列化 template.setHashKeySerializer(stringRedisSerializer); //value序列化方式采用jackson template.setValueSerializer(jackson2JsonRedisSerializer); //hash的value序列化方式采用jackson template.setHashValueSerializer(jackson2JsonRedisSerializer); template.afterPropertiesSet(); return template; } } -

redis.conf配置文件笔记 单位# 不区分大小写 # 1k => 1000 bytes # 1kb => 1024 bytes # 1m => 1000000 bytes # 1mb => 1024*1024 bytes # 1g => 1000000000 bytes # 1gb => 1024*1024*1024 bytesinclude# 包含,类似于Spring的import,include include /path/to/local.conf include /path/to/other.conf网络bind 127.0.0.1 #绑定的IP,*代表允许全部访问 protected-mode yes #保护模式 port 6379 #端口通用配置 GENERALdaemonize yes #以进程守护的方式运行,默认值为no,需手动设置 pidfile /var/run/redis_6379.pid #如果以后台方式运行,需要指定一个pid文件 # 日志 # Specify the server verbosity level. # This can be one of: # debug (a lot of information, useful for development/testing) 开发/测试环境 # verbose (many rarely useful info, but not a mess like the debug level) # notice (moderately verbose, what you want in production probably) 生产环境 # warning (only very important / critical messages are logged) loglevel notice logfile "" #日志的文件位置/名字 databases 16 #数据库的数量,默认为16个 always-show-logo yes #是否总是显示Redis的logo快照 SNAPSHOTTING持久化,在规定的时间内,执行了多少次操作,则会持久化到文件 .aof .rdb#在900秒内,如果至少有 1 key进行了修改,就进行持久化操作 save 900 1 #在300秒内,如果至少有 10 key进行了修改,就进行持久化操作 save 300 10 #在60秒内,如果至少有 10000 key进行了修改,就进行持久化操作 save 60 10000 stop-writes-on-bgsave-error yes #持久化操作出错时是否继续进行,默认为yes rdbcompression yes #是否压缩rdb文件,默认为yes rdbchecksum yes #保存rdb文件时,是否进行错误校验,默认为yes dir ./ #rdb文件保存的目录主从复制 REPLICATION安全 SECURITYconfig get requirepass #获取redis密码 config set requirepass "123" #设置redis密码限制 CLIENTSmaxclients 10000 #客户端最大默认连接数量 maxmemory <bytes> #配置redis最大内存,默认单位为字节 maxmemory-policy noeviction #内存达到上限之后的处理策略 volatile-lru:只对设置了过期时间的key进行LRU(默认值) allkeys-lru : 删除lru算法的key volatile-random:随机删除即将过期key allkeys-random:随机删除 volatile-ttl : 删除即将过期的 noeviction : 永不过期,返回错误APPEND ONLY MODE aof配置appendonly no #默认不开启(redis默认使用的是rdb持久化方式,通常情况下,rdb完全够用了) appendfilename "appendonly.aof" #持久化文件的名字 # appendfsync always #每次修改都会 sync,消耗性能 appendfsync everysec #每秒执行一次 sync,特殊情况下可能会丢失这一秒的数据(宕机) # appendfsync no #不执行 sync,由操作系统自己同步数据

redis.conf配置文件笔记 单位# 不区分大小写 # 1k => 1000 bytes # 1kb => 1024 bytes # 1m => 1000000 bytes # 1mb => 1024*1024 bytes # 1g => 1000000000 bytes # 1gb => 1024*1024*1024 bytesinclude# 包含,类似于Spring的import,include include /path/to/local.conf include /path/to/other.conf网络bind 127.0.0.1 #绑定的IP,*代表允许全部访问 protected-mode yes #保护模式 port 6379 #端口通用配置 GENERALdaemonize yes #以进程守护的方式运行,默认值为no,需手动设置 pidfile /var/run/redis_6379.pid #如果以后台方式运行,需要指定一个pid文件 # 日志 # Specify the server verbosity level. # This can be one of: # debug (a lot of information, useful for development/testing) 开发/测试环境 # verbose (many rarely useful info, but not a mess like the debug level) # notice (moderately verbose, what you want in production probably) 生产环境 # warning (only very important / critical messages are logged) loglevel notice logfile "" #日志的文件位置/名字 databases 16 #数据库的数量,默认为16个 always-show-logo yes #是否总是显示Redis的logo快照 SNAPSHOTTING持久化,在规定的时间内,执行了多少次操作,则会持久化到文件 .aof .rdb#在900秒内,如果至少有 1 key进行了修改,就进行持久化操作 save 900 1 #在300秒内,如果至少有 10 key进行了修改,就进行持久化操作 save 300 10 #在60秒内,如果至少有 10000 key进行了修改,就进行持久化操作 save 60 10000 stop-writes-on-bgsave-error yes #持久化操作出错时是否继续进行,默认为yes rdbcompression yes #是否压缩rdb文件,默认为yes rdbchecksum yes #保存rdb文件时,是否进行错误校验,默认为yes dir ./ #rdb文件保存的目录主从复制 REPLICATION安全 SECURITYconfig get requirepass #获取redis密码 config set requirepass "123" #设置redis密码限制 CLIENTSmaxclients 10000 #客户端最大默认连接数量 maxmemory <bytes> #配置redis最大内存,默认单位为字节 maxmemory-policy noeviction #内存达到上限之后的处理策略 volatile-lru:只对设置了过期时间的key进行LRU(默认值) allkeys-lru : 删除lru算法的key volatile-random:随机删除即将过期key allkeys-random:随机删除 volatile-ttl : 删除即将过期的 noeviction : 永不过期,返回错误APPEND ONLY MODE aof配置appendonly no #默认不开启(redis默认使用的是rdb持久化方式,通常情况下,rdb完全够用了) appendfilename "appendonly.aof" #持久化文件的名字 # appendfsync always #每次修改都会 sync,消耗性能 appendfsync everysec #每秒执行一次 sync,特殊情况下可能会丢失这一秒的数据(宕机) # appendfsync no #不执行 sync,由操作系统自己同步数据 -

Jedis Redis官方推荐的Java开发连接工具导入依赖:<dependency> <groupId>redis.clients</groupId> <artifactId>jedis</artifactId> <version>3.2.0</version> </dependency>测试类:package com.sw; import redis.clients.jedis.Jedis; /** * @Author suaxi * @Date 2021/1/2 11:40 */ public class TestPing { public static void main(String[] args) { Jedis jedis = new Jedis("服务器IP地址", 6379); jedis.auth("密码"); System.out.println(jedis.ping()); //PONG } } 注:SpringBoot 2.0之后默认采用lettuce

Jedis Redis官方推荐的Java开发连接工具导入依赖:<dependency> <groupId>redis.clients</groupId> <artifactId>jedis</artifactId> <version>3.2.0</version> </dependency>测试类:package com.sw; import redis.clients.jedis.Jedis; /** * @Author suaxi * @Date 2021/1/2 11:40 */ public class TestPing { public static void main(String[] args) { Jedis jedis = new Jedis("服务器IP地址", 6379); jedis.auth("密码"); System.out.println(jedis.ping()); //PONG } } 注:SpringBoot 2.0之后默认采用lettuce -

Redis特殊数据类型Bitmap Bitmap位图位存储,通过操作二进制位来进行记录,只有0和1两个状态统计打卡天数Demo(0:未打卡,1:打卡)127.0.0.1:6379> SETBIT daka 1 1 #设置周一打卡状态 (integer) 0 127.0.0.1:6379> SETBIT daka 2 1 (integer) 0 127.0.0.1:6379> SETBIT daka 3 0 (integer) 0 127.0.0.1:6379> SETBIT daka 4 1 (integer) 0 127.0.0.1:6379> SETBIT daka 5 0 (integer) 0 127.0.0.1:6379> SETBIT daka 6 1 (integer) 0 127.0.0.1:6379> SETBIT daka 7 0 (integer) 0 127.0.0.1:6379> GETBIT daka 5 #查看周五是否打卡 (integer) 0 #返回值为0,未打卡 127.0.0.1:6379> GETBIT daka 6 (integer) 1 127.0.0.1:6379> BITCOUNT daka #统计一周的打卡情况 (integer) 4 127.0.0.1:6379>

Redis特殊数据类型Bitmap Bitmap位图位存储,通过操作二进制位来进行记录,只有0和1两个状态统计打卡天数Demo(0:未打卡,1:打卡)127.0.0.1:6379> SETBIT daka 1 1 #设置周一打卡状态 (integer) 0 127.0.0.1:6379> SETBIT daka 2 1 (integer) 0 127.0.0.1:6379> SETBIT daka 3 0 (integer) 0 127.0.0.1:6379> SETBIT daka 4 1 (integer) 0 127.0.0.1:6379> SETBIT daka 5 0 (integer) 0 127.0.0.1:6379> SETBIT daka 6 1 (integer) 0 127.0.0.1:6379> SETBIT daka 7 0 (integer) 0 127.0.0.1:6379> GETBIT daka 5 #查看周五是否打卡 (integer) 0 #返回值为0,未打卡 127.0.0.1:6379> GETBIT daka 6 (integer) 1 127.0.0.1:6379> BITCOUNT daka #统计一周的打卡情况 (integer) 4 127.0.0.1:6379> -

Redis基本事务操作 关系型数据库:ACID原则非关系型数据库:Redis事务是一组命令的集合,一个事务中的所有命令都会被序列化,在事务执行的过程中顺序执行(一次性、顺序性、排他性)redis的单条命令是保证原子性的,但事务不保证原子性事务中所有的命令并没有被直接执行,只有发起执行命令(Exec)时才会执行redis的事务:开启事务(multi)命令入队执行事务(exec)正常执行事务127.0.0.1:6379> MULTI #开启事务 OK 127.0.0.1:6379> set key01 hello #命令入队 QUEUED 127.0.0.1:6379> set key02 nihao QUEUED 127.0.0.1:6379> get key01 QUEUED 127.0.0.1:6379> set key03 xiexie QUEUED 127.0.0.1:6379> EXEC #执行事务 1) OK 2) OK 3) "hello" 4) OK 127.0.0.1:6379> 取消事务127.0.0.1:6379> MULTI #开启事务 OK 127.0.0.1:6379> set key01 hello QUEUED 127.0.0.1:6379> set key02 nihao QUEUED 127.0.0.1:6379> set key03 xiexie QUEUED 127.0.0.1:6379> DISCARD #取消事务 OK 127.0.0.1:6379> get key03 #事务队列中的命令都不会被执行,此处查询结果为空 (nil) 127.0.0.1:6379> 编译型异常(代码中存在错误),事务中的所有命令都不会被执行127.0.0.1:6379> MULTI #开启事务 OK 127.0.0.1:6379> set k1 v1 QUEUED 127.0.0.1:6379> set k2 v2 QUEUED 127.0.0.1:6379> getset k3 (error) ERR wrong number of arguments for 'getset' command 127.0.0.1:6379> set k4 v4 QUEUED 127.0.0.1:6379> EXEC #执行事务报错 (error) EXECABORT Transaction discarded because of previous errors. 127.0.0.1:6379> get k1 #事务队列中的所有命令都没有被执行 (nil) 127.0.0.1:6379> 运行时异常(1/0问题),事务队列中除有问题的语句外其他的都会被执行(无原子性)127.0.0.1:6379> set k1 hello OK 127.0.0.1:6379> MULTI OK 127.0.0.1:6379> INCR k1 #字符串不能自增 QUEUED 127.0.0.1:6379> set k2 v2 QUEUED 127.0.0.1:6379> set k3 v3 QUEUED 127.0.0.1:6379> get k3 QUEUED 127.0.0.1:6379> EXEC 1) (error) ERR value is not an integer or out of range #自增语句执行失败,其后的语句执行成功 2) OK 3) OK 4) "v3" 127.0.0.1:6379> get k2 "v2" 127.0.0.1:6379> get k3 "v3" 127.0.0.1:6379> Watch监控悲观锁:认为什么时候都会出现问题,无论做什么都会加锁乐观锁:认为什么时候都不会出现问题,不会上锁,在更新数据的时候会去判断在此期间是否有人修改过数据获取version更新的时候比较versionRedis监视测试:# 正常执行 127.0.0.1:6379> set money 100 OK 127.0.0.1:6379> set out 0 OK 127.0.0.1:6379> watch money OK 127.0.0.1:6379> MULTI OK 127.0.0.1:6379> DECRBY money 20 QUEUED 127.0.0.1:6379> INCRBY out 20 QUEUED 127.0.0.1:6379> EXEC 1) (integer) 80 2) (integer) 20 127.0.0.1:6379> 乐观锁:(常用于电商秒杀系统)127.0.0.1:6379> WATCH money #监视money OK 127.0.0.1:6379> MULTI OK 127.0.0.1:6379> DECRBY money 10 QUEUED 127.0.0.1:6379> INCRBY out 10 QUEUED 127.0.0.1:6379> EXEC #在执行之前有其他的线程修改了money,会导致这里的事务执行失败 (nil) 127.0.0.1:6379> 127.0.0.1:6379> UNWATCH #如果发现事务执行失败,就先解锁 OK 127.0.0.1:6379> watch money #再次监控,获取最新的值 OK 127.0.0.1:6379> MULTI OK 127.0.0.1:6379> DECRBY money 10 QUEUED 127.0.0.1:6379> INCRBY money 5 QUEUED 127.0.0.1:6379> exec #对比监控的信息是否发生了变化,如果没有,则执行成功,否则执行失败 1) (integer) 0 2) (integer) 5 127.0.0.1:6379>

Redis基本事务操作 关系型数据库:ACID原则非关系型数据库:Redis事务是一组命令的集合,一个事务中的所有命令都会被序列化,在事务执行的过程中顺序执行(一次性、顺序性、排他性)redis的单条命令是保证原子性的,但事务不保证原子性事务中所有的命令并没有被直接执行,只有发起执行命令(Exec)时才会执行redis的事务:开启事务(multi)命令入队执行事务(exec)正常执行事务127.0.0.1:6379> MULTI #开启事务 OK 127.0.0.1:6379> set key01 hello #命令入队 QUEUED 127.0.0.1:6379> set key02 nihao QUEUED 127.0.0.1:6379> get key01 QUEUED 127.0.0.1:6379> set key03 xiexie QUEUED 127.0.0.1:6379> EXEC #执行事务 1) OK 2) OK 3) "hello" 4) OK 127.0.0.1:6379> 取消事务127.0.0.1:6379> MULTI #开启事务 OK 127.0.0.1:6379> set key01 hello QUEUED 127.0.0.1:6379> set key02 nihao QUEUED 127.0.0.1:6379> set key03 xiexie QUEUED 127.0.0.1:6379> DISCARD #取消事务 OK 127.0.0.1:6379> get key03 #事务队列中的命令都不会被执行,此处查询结果为空 (nil) 127.0.0.1:6379> 编译型异常(代码中存在错误),事务中的所有命令都不会被执行127.0.0.1:6379> MULTI #开启事务 OK 127.0.0.1:6379> set k1 v1 QUEUED 127.0.0.1:6379> set k2 v2 QUEUED 127.0.0.1:6379> getset k3 (error) ERR wrong number of arguments for 'getset' command 127.0.0.1:6379> set k4 v4 QUEUED 127.0.0.1:6379> EXEC #执行事务报错 (error) EXECABORT Transaction discarded because of previous errors. 127.0.0.1:6379> get k1 #事务队列中的所有命令都没有被执行 (nil) 127.0.0.1:6379> 运行时异常(1/0问题),事务队列中除有问题的语句外其他的都会被执行(无原子性)127.0.0.1:6379> set k1 hello OK 127.0.0.1:6379> MULTI OK 127.0.0.1:6379> INCR k1 #字符串不能自增 QUEUED 127.0.0.1:6379> set k2 v2 QUEUED 127.0.0.1:6379> set k3 v3 QUEUED 127.0.0.1:6379> get k3 QUEUED 127.0.0.1:6379> EXEC 1) (error) ERR value is not an integer or out of range #自增语句执行失败,其后的语句执行成功 2) OK 3) OK 4) "v3" 127.0.0.1:6379> get k2 "v2" 127.0.0.1:6379> get k3 "v3" 127.0.0.1:6379> Watch监控悲观锁:认为什么时候都会出现问题,无论做什么都会加锁乐观锁:认为什么时候都不会出现问题,不会上锁,在更新数据的时候会去判断在此期间是否有人修改过数据获取version更新的时候比较versionRedis监视测试:# 正常执行 127.0.0.1:6379> set money 100 OK 127.0.0.1:6379> set out 0 OK 127.0.0.1:6379> watch money OK 127.0.0.1:6379> MULTI OK 127.0.0.1:6379> DECRBY money 20 QUEUED 127.0.0.1:6379> INCRBY out 20 QUEUED 127.0.0.1:6379> EXEC 1) (integer) 80 2) (integer) 20 127.0.0.1:6379> 乐观锁:(常用于电商秒杀系统)127.0.0.1:6379> WATCH money #监视money OK 127.0.0.1:6379> MULTI OK 127.0.0.1:6379> DECRBY money 10 QUEUED 127.0.0.1:6379> INCRBY out 10 QUEUED 127.0.0.1:6379> EXEC #在执行之前有其他的线程修改了money,会导致这里的事务执行失败 (nil) 127.0.0.1:6379> 127.0.0.1:6379> UNWATCH #如果发现事务执行失败,就先解锁 OK 127.0.0.1:6379> watch money #再次监控,获取最新的值 OK 127.0.0.1:6379> MULTI OK 127.0.0.1:6379> DECRBY money 10 QUEUED 127.0.0.1:6379> INCRBY money 5 QUEUED 127.0.0.1:6379> exec #对比监控的信息是否发生了变化,如果没有,则执行成功,否则执行失败 1) (integer) 0 2) (integer) 5 127.0.0.1:6379> -

Redis特殊数据类型geospatial geospatial 地理位置Redis 3.2推出操作以GEO开头GEOADD# geoadd 添加地理位置(两极地区无法直接添加) # 有效精度-180~180 # 有效纬度-85.05112878~85.05112878 # 参数 key 值() 127.0.0.1:6379> GEOADD china:city 116.40 39.90 beijing (integer) 1 127.0.0.1:6379> GEOADD china:city 121.47 31.23 shanghai 106.50 29.53 chongqing (integer) 2 127.0.0.1:6379> GEOADD china:city 114.05 22.52 shenzhen 120.16 30.24 hangzhou 108.96 34.26 xian (integer) 3 127.0.0.1:6379> GEOPOS# GEOPOS 获取指定城市的精度和纬度 127.0.0.1:6379> GEOPOS china:city hangzhou chongqing 1) 1) "120.1600000262260437" 2) "30.2400003229490224" 2) 1) "106.49999767541885376" 2) "29.52999957900659211" 127.0.0.1:6379> GEODIST查看两地之间的直线距离,单位默认为m,也可以手动指定m 米km 千米mi 英里ft 英尺# GEODIST 127.0.0.1:6379> GEODIST china:city beijing shanghai #北京到上海的直线距离 "1067378.7564" 127.0.0.1:6379> GEODIST china:city beijing shanghai km "1067.3788" 127.0.0.1:6379> GEORADIUS 以给定的经纬度为中心,找出某一半径内的元素注:所有的城市数据都应存入china:city,此处只以录入的少量数据为例# GEORADIUS 127.0.0.1:6379> GEORADIUS china:city 114 22 500 km #以114 22这个经纬度为中心,半径为500km范围内的城市 1) "shenzhen" 127.0.0.1:6379> GEORADIUS china:city 114 22 1000 km 1) "shenzhen" 127.0.0.1:6379> GEORADIUS china:city 114 22 1000 km withdist #到中心位置的距离 1) 1) "shenzhen" 2) "58.0662" 127.0.0.1:6379> GEORADIUS china:city 114 22 1000 km withcoord #附近城市的经纬度 1) 1) "shenzhen" 2) 1) "114.04999762773513794" 2) "22.5200000879503861" 127.0.0.1:6379> GEORADIUS china:city 114 22 1000 km withdist withcoord count 2 #距离、经纬度、筛选指定数量的结果 1) 1) "shenzhen" 2) "58.0662" 3) 1) "114.04999762773513794" 2) "22.5200000879503861" 127.0.0.1:6379> GEORADIUSBYMEMBER# 查找指定元素周围的其他元素 127.0.0.1:6379> GEORADIUSBYMEMBER china:city shanghai 1000 km 1) "hangzhou" 2) "shanghai" 127.0.0.1:6379> GEOHASH返回11个字符的geohash字符串# GEOHASH 将二维的精度转换为一维的字符串(两个字符串越接近,表示距离越近) 127.0.0.1:6379> GEOHASH china:city hangzhou shenzhen 1) "wtmkn31bfb0" 2) "ws10578st80" 127.0.0.1:6379> GEO底层的实现原理就是ZsetRedis官方文档中的GEO没有提供移除元素的操作,但可以通过zrem来移除元素127.0.0.1:6379> ZRANGE china:city 0 -1 1) "chongqing" 2) "xian" 3) "shenzhen" 4) "hangzhou" 5) "shanghai" 6) "beijing" 127.0.0.1:6379> ZREM china:city shanghai # 移除指定的元素 (integer) 1 127.0.0.1:6379> ZRANGE china:city 0 -1 1) "chongqing" 2) "xian" 3) "shenzhen" 4) "hangzhou" 5) "beijing" 127.0.0.1:6379>

Redis特殊数据类型geospatial geospatial 地理位置Redis 3.2推出操作以GEO开头GEOADD# geoadd 添加地理位置(两极地区无法直接添加) # 有效精度-180~180 # 有效纬度-85.05112878~85.05112878 # 参数 key 值() 127.0.0.1:6379> GEOADD china:city 116.40 39.90 beijing (integer) 1 127.0.0.1:6379> GEOADD china:city 121.47 31.23 shanghai 106.50 29.53 chongqing (integer) 2 127.0.0.1:6379> GEOADD china:city 114.05 22.52 shenzhen 120.16 30.24 hangzhou 108.96 34.26 xian (integer) 3 127.0.0.1:6379> GEOPOS# GEOPOS 获取指定城市的精度和纬度 127.0.0.1:6379> GEOPOS china:city hangzhou chongqing 1) 1) "120.1600000262260437" 2) "30.2400003229490224" 2) 1) "106.49999767541885376" 2) "29.52999957900659211" 127.0.0.1:6379> GEODIST查看两地之间的直线距离,单位默认为m,也可以手动指定m 米km 千米mi 英里ft 英尺# GEODIST 127.0.0.1:6379> GEODIST china:city beijing shanghai #北京到上海的直线距离 "1067378.7564" 127.0.0.1:6379> GEODIST china:city beijing shanghai km "1067.3788" 127.0.0.1:6379> GEORADIUS 以给定的经纬度为中心,找出某一半径内的元素注:所有的城市数据都应存入china:city,此处只以录入的少量数据为例# GEORADIUS 127.0.0.1:6379> GEORADIUS china:city 114 22 500 km #以114 22这个经纬度为中心,半径为500km范围内的城市 1) "shenzhen" 127.0.0.1:6379> GEORADIUS china:city 114 22 1000 km 1) "shenzhen" 127.0.0.1:6379> GEORADIUS china:city 114 22 1000 km withdist #到中心位置的距离 1) 1) "shenzhen" 2) "58.0662" 127.0.0.1:6379> GEORADIUS china:city 114 22 1000 km withcoord #附近城市的经纬度 1) 1) "shenzhen" 2) 1) "114.04999762773513794" 2) "22.5200000879503861" 127.0.0.1:6379> GEORADIUS china:city 114 22 1000 km withdist withcoord count 2 #距离、经纬度、筛选指定数量的结果 1) 1) "shenzhen" 2) "58.0662" 3) 1) "114.04999762773513794" 2) "22.5200000879503861" 127.0.0.1:6379> GEORADIUSBYMEMBER# 查找指定元素周围的其他元素 127.0.0.1:6379> GEORADIUSBYMEMBER china:city shanghai 1000 km 1) "hangzhou" 2) "shanghai" 127.0.0.1:6379> GEOHASH返回11个字符的geohash字符串# GEOHASH 将二维的精度转换为一维的字符串(两个字符串越接近,表示距离越近) 127.0.0.1:6379> GEOHASH china:city hangzhou shenzhen 1) "wtmkn31bfb0" 2) "ws10578st80" 127.0.0.1:6379> GEO底层的实现原理就是ZsetRedis官方文档中的GEO没有提供移除元素的操作,但可以通过zrem来移除元素127.0.0.1:6379> ZRANGE china:city 0 -1 1) "chongqing" 2) "xian" 3) "shenzhen" 4) "hangzhou" 5) "shanghai" 6) "beijing" 127.0.0.1:6379> ZREM china:city shanghai # 移除指定的元素 (integer) 1 127.0.0.1:6379> ZRANGE china:city 0 -1 1) "chongqing" 2) "xian" 3) "shenzhen" 4) "hangzhou" 5) "beijing" 127.0.0.1:6379> -

Redis特殊数据类型Hyperloglog HyperloglogRedis 2.8.9引入,用于基数统计的算法可以用于网页UV统计,即一个人在一天的时间内多次访问同一个网站,访问次数虽多,但只能算作一个访客hyperloglog优点:占用的内存是固定的,存放2^64个不同的基数,只需12kb内存,0.81%的错误率可以忽略不计127.0.0.1:6379> PFADD mykey01 c s k h t b f r f c # 创建第一组元素mykey01 (integer) 1 127.0.0.1:6379> PFCOUNT mykey01 #统计mykey元素的基数数量 (integer) 8 127.0.0.1:6379> PFADD mykey02 h k i g f c v d a e s # 同上 (integer) 1 127.0.0.1:6379> PFCOUNT mykey02 (integer) 11 127.0.0.1:6379> PFMERGE mykey03 mykey01 mykey02 #并集 OK 127.0.0.1:6379> PFCOUNT mykey03 #统计并集的基数数量 (integer) 13 127.0.0.1:6379>

Redis特殊数据类型Hyperloglog HyperloglogRedis 2.8.9引入,用于基数统计的算法可以用于网页UV统计,即一个人在一天的时间内多次访问同一个网站,访问次数虽多,但只能算作一个访客hyperloglog优点:占用的内存是固定的,存放2^64个不同的基数,只需12kb内存,0.81%的错误率可以忽略不计127.0.0.1:6379> PFADD mykey01 c s k h t b f r f c # 创建第一组元素mykey01 (integer) 1 127.0.0.1:6379> PFCOUNT mykey01 #统计mykey元素的基数数量 (integer) 8 127.0.0.1:6379> PFADD mykey02 h k i g f c v d a e s # 同上 (integer) 1 127.0.0.1:6379> PFCOUNT mykey02 (integer) 11 127.0.0.1:6379> PFMERGE mykey03 mykey01 mykey02 #并集 OK 127.0.0.1:6379> PFCOUNT mykey03 #统计并集的基数数量 (integer) 13 127.0.0.1:6379>